Nicht nur Intel, auch Konkurrent AMD macht bei der Ankündigung neuer Produkte manchmal Versprechen, die sich anschließend nicht halten lassen. Seit der Übernahme von ATI hat AMD sogar zwei Bereiche, in denen dies passieren kann und passiert ist.

ATI Rage Fury MAXX

Die Rage Fury MAXX, eine Sackgasse für ATI

Noch lange vor der Übernahme durch AMD hatte ATI mit der Rage Fury MAXX seinen ersten richtigen, großen Flop. Die Grafikkarte sollte mit zwei RAGE 128 Pro-Grafikchips die Bilder abwechselnd berechnen (Alternate Frame Rendering) und so gegen die GeForce 256 und die 3dfx Voodoo 5 antreten. Doch auch mit zwei Grafikchips unterlag die ATI-Karte zumindest der GeForce 256 mit DDR-Speicher und besaß darüber hinaus auch keine Transform & Lighting-Fähigkeiten. Als dann noch klar wurde, dass die neuen, auf Windows NT basierenden Betriebssysteme Windows 2000 und Windows XP AGP-Karten mit zwei Grafikchips nicht mit der von ATI genutzten Technik unterstützten und nur einen der Chips ansprachen, war die Karte gescheitert. Das Konzept mit zwei Grafikchips auf einer Karte sollte jedoch Jahre später mit den Radeon X2-Modellen wieder zu Erfolgen für ATI führen.

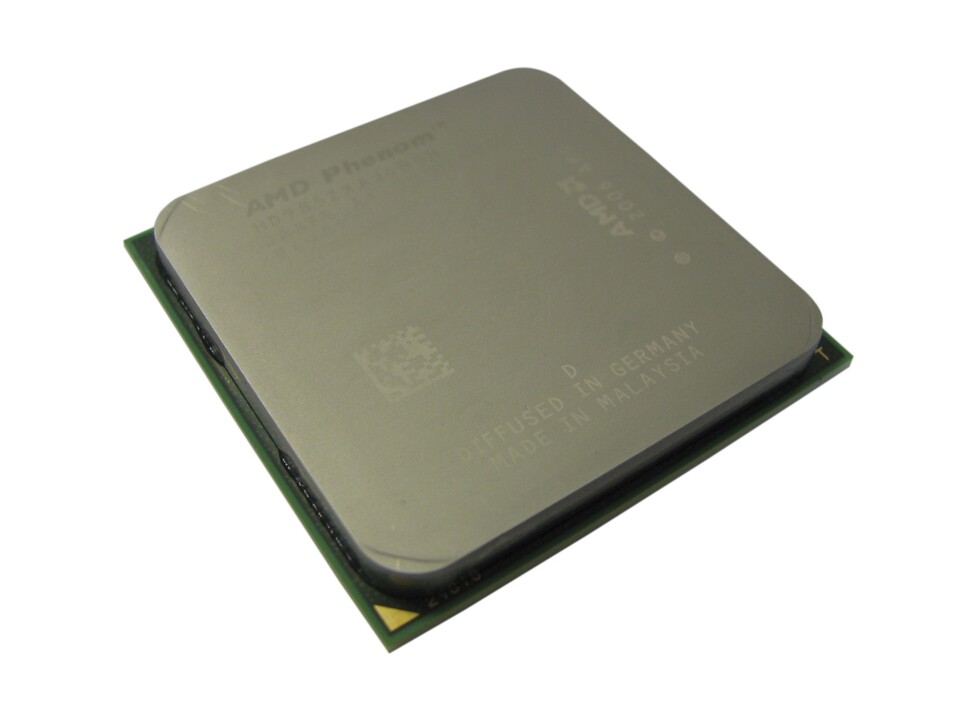

AMD Phenom / Barcelona

Der AMD Phenom war in der ersten Version kein Erfolg

Nachdem Intel mit den Core 2 Quad-Prozessoren Anfang 2007 die ersten Vierkern-CPUs auf den Markt brachte, reagierte AMD mit aggressiven Ankündigungen zu den Vorteilen eines "echten, nativen" Quadcores mit integriertem Speichercontroller, der von Grund auf entwickelt worden sei. Tatsächlich waren und sind alle Intel Core 2 Quad-Prozessoren im Grunde zwei Dualcores auf einem Chip, doch die Versprechungen von 40 oder gar 50 Prozent Mehrleistung durch AMD erfüllten sich nicht. Der K10-Kern "Barcelona" verzögerte sich um ein halbes Jahr und als die Phenom-X4-Prozessoren schließlich Ende 2007 erschienen, waren sie auch aufgrund niedriger Taktfrequenzen nicht in der Lage, die Intel-Konkurrenz zu schlagen.

Schlimmer noch, der sogenannte TLB-Fehler, der nur selten auftrat, sorgte für weitere schlechte Presse, da dessen Behebung weitere Leistung kostete. Erst im Frühling 2008 kamen etwas schnellere und fehlerbereinigte Versionen auf den Markt. Erfolg hatte AMD jedoch erst mit den neuen Phenom II-Prozessoren, die zur Zeit in 45 nm hergestellt werden und ein sehr gutes Preis-Leistungs-Verhältnis bieten.

ATI Radeon HD 2900 XT

Zu heiß und zu laut: die ATI Radeon HD 2900 XT

Nvidia hatte mit seiner GeForce-8000-Serie im November 2006 das DirectX-10-Zeitalter bei den Grafikkarten eingeläutet und gleichzeitig Karten auf den Markt gebracht, die auch unter DirectX 9 rasend schnell waren. ATI konnte erst im Mai 2007 seine erste DirectX-10-Karte vorstellen, die Radeon HD 2900 XT. Die Karte besaß einen sehr lauten Lüfter, einen hohen Stromverbrauch und war der gleichzeitig erschienenen GeForce 8800 Ultra unterlegen. Erst durch die Strukturverkleinerung der Grafikchips bei der Radeon-HD-3800-Serie konnte ATI ab November 2007 wieder ansprechende Karten anbieten und hatte somit ein Jahr lang Nvidia das Spielfeld überlassen.

Nvidia GeForce FX 5800 Ultra

Der berühmte Laubsauger GeForce Fx 5800 Ultra

Ein noch größeres Fiasko als ATI mit der Radeon HD 2900 XT erlebte Nvidia Anfang 2003 mit seiner GeForce FX 5800 Ultra. Durch ATI und die Radeon 9700 Pro unter Druck gesetzt, veröffentlichte Nvidia seine neue Karte, die schon grundsätzlich viele Probleme hatte. DirectX 9 erforderte eine Präzision von mindestens 24 Bit, und während ATI-Karten hier auch 24 Bit einsetzten, bot die GeForce FX 5800 Ultra nur 16 oder 32 Bit an. Sie war also entweder nicht DirectX-9-kompatibel oder deutlich langsamer bei höherer Präzision. Nvidia versuchte dies durch zwangsweises Nutzen von 16 Bit in den Treibern zu verschleiern, stoppte diese Taktik jedoch nach negativen Schlagzeilen wieder. Der lärmende Lüfter der ersten Modelle, der den Karten Spitznamen wie "Laubsauger" einbrachte, machten die GeForce FX 5800 Ultra endgültig zu einem Flop.

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.