Die Hersteller von Grafikprozessoren jagen gemeinsam mit den Spiele-Programmierern ein bewegliches Ziel: die Bildqualität von Spezialeffekten in Actionfilmen wie Transformers und Animationsstreifen wie Shrek. Zwar entwickelt sich auch auf der PC-Seite die Technologie mit Riesenschritten vorwärts, aber ein wesentlicher Unterschied zum Film bleibt. Während Spiele in Echtzeit berechnet werden, können sich die Filmstudios viel Zeit lassen. Hollywood setzt gigantische Server- Farmen für die Spezialeffekte ein – Raytracing ist hier bereits Realität. Bei Licht, Schatten und Reflektionen kommt diese Technik verdammt nah an das heran, was wir vor Augen haben, wenn wir nicht am Computer sitzen. Ein aktueller Spiele-PC würde allein mit einem einzelnen Shrek- Frame wochenlang beschäftigt sein.

Das ist die eigentliche Herausforderung moderner 3D-Grafik: Sie soll aussehen wie im Kino, aber in Echtzeit laufen. Vor allem mit DirectX 11 und einer neuen Hardware-Generation wollen AMD, Nvidia und Microsoft diesem Ziel in den nächsten Jahren wieder ein Stück näher kommen. Welche Effekte dabei die wichtigste Rolle spielen, was sie bringen und wie sie genau funktionieren, das erklären wir in diesem Hardware- Schwerpunkt.

1990

Bis Mitte der 1980er Jahre beschränkten sich PC-Spiele auf zwei Dimensionen. Eine gängige Auflösung war damals 640x350 – maximal 224.000 grobe 2D-Klötzchen standen zur Darstellung von Spielwelt, Charakteren und Bedienelementen zur Verfügung (ein 22-Zoll-TFT hat 1,764 Millionen Pixel).

Aber bereits seit den 1970er Jahren liegen an den Universitäten zwei Konzepte für virtuelle 3D-Welten in der Schublade: Rasterisierung und Raytracing. Rasterisierung versucht mit möglichst wenig Rechenaufwand eine optisch glaubwürdige Annäherung an die reale Welt, Raytracing folgt eher den physikalischen Gegebenheiten auf unserem Planeten und ist deshalb exakter, aber für Echtzeit-Anwendungen wie Spiele bis heute zu langsam.

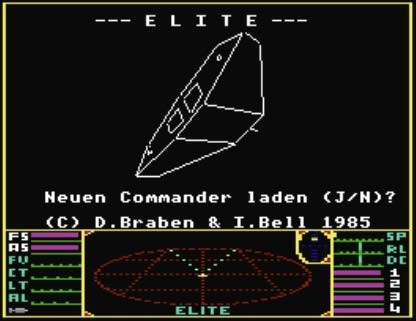

Der PC betritt schließlich 1987 mit dem Weltraum-Spiel Elite die dritte Dimension. Eine Handvoll Polygone mussten reichen, mehr konnte die Hardware nicht bewerkstelligen. Über die Jahre wurden die anfangs nackten Polygone mit Texturen beklebt und immer mehr Details ausgearbeitet. Bis 1996 mussten wir uns gedulden, bevor id Software mit Quake das erste komplett in 3D berechnete Spiel veröffentlichte. Derweil setzten sich 3D-Beschleuniger wie die Voodoo durch. Vier Jahre später erschien mit der Geforce 2 die letzte Hardware-Generation dieser 3D-Ära, bevor Nvidia ein Jahr danach mit der Geforce 3 und ihrer Shader-Technologie das Zeitalter programmierbarer Grafikchips einläutete.

2000

Im heutigen Shader-Zeitalter verschwimmen die Grenzen zwischen CPU und Grafikkarte sowie zwischen Rasterisierung und Raytracing. Seit DirectX 8 und der Geforce 3 beherrschen Grafikkarten nicht mehr nur vorher festgelegte Funktionen (wie zum Beispiel eine Textur auf ein Polygon zu kleben), sondern sie können mit ihren Shader-Prozessoren komplexe Programme ausführen. 2002 nutzte Morrowind das, um für damalige Verhältnisse beeindruckende Wasserspiegelungen darzustellen.

Jedoch schränkt DirectX 8 die Programmier noch stark ein. DirectX 9 (Radeon HD 9800, Geforce FX) war dann bereits so flexibel, dass sich praktisch jede denkbare Berechnung auf den Shadern durchführen ließ. Einzig die maximal mögliche Rechenleistung begrenzte den Freiraum der Spiele-Entwickler. Die meisten modernen Effekte realisieren die Programierer über Shader, egal ob Physik, Tesselation, Parallax Occlusion Mapping oder Post-Processing. Viele dieser Effekte sind aber bestenfalls Annäherungen an die Realität. Es sind Tricks, um bei zivilem Rechenaufwand eine optisch spektakuläre 3D-Grafik hinzubekommen. Parallax Occlusion Mapping zum Beispiel kam zuerst in Splinter Cell: Chaos Theory zum Einsatz und bildet Backsteinwände oder ähnliche Strukturen plastisch nach. Wenn Sie eine derart texturierte Wand in einem sehr flachen Winkel betrachten, verrät sich der Trick jedoch: Letztlich handelt es sich um eine platte Textur, also eine Fototapete. Mit der vom kommenden DirectX 11 unterstützten Tesselation-Technik lassen sich die einzelnen Backsteine effizient aus Polygonen modellieren. Moderne Grafikkarten arbeiten so schnell, dass manche Shader-Programme sogar vereinfachte Raytracing-Algorithmen (Raycasting) nutzen. Oftmals zum Überprüfen von sichtbaren Objekten oder als Annäherung an eine glaubwürdige globale Beleuchtung.

2010

Prompt entbrannte zwischen AMD und Nvidia ein Wettlauf um die erste DirectX-11-Grafikkarte, den AMD für klar für sich entscheiden konnte. Pünktlich zum Start von Windows 7 und DirectX 11 am 22. Oktober sind mit der Radeon HD 5870, Radeon HD 5850 und Radeon HD 5770 drei passende Grafikkarte zwischen 150 und 350 Euro erhältlich. Nvidia wird nach aktuellem Stand frühestens Ende Dezember zurückschlagen.

Unterdessen arbeitet Intel mit Hochdruck an seiner ersten »richtigen « Grafikkarte seit Jahren. Larrabee, so der vorläufige Name, geht Ende dieses Jahres an Entwickler und soll Ende des nächsten Jahres in einer zweiten Generation offiziell auf den Markt kommen. Intel verspricht: Larrabee beherrscht Echtzeit-Raytracing in hoher Qualität. Auf der Computergrafik-Messe Siggraph hat Nvidia unterdessen den ersten Echtzeit- Raytracer für seine Grafikkarten vorgestellt. Ohne frei programmierbare Shader wäre dies gar nicht möglich. Bisher läuft der Raytracer ausschließlich auf den teuren Quadro-Karten. Da die sich aber kaum von einer handelsüblichen Geforce mit gleichem Grafikchip unterscheiden, liegt der Einsatz von Raytracing in Spielen auch bei Nvidia vermutlich nicht mehr allzu fern (auch AMD forscht in dieser Richtung).

Wenn Raytracing in den nächsten Jahren tatsächlich in Spielen ankommen sollte, ist zwar die 3D-Grafik nahe an der Perfektion, aber der Monitor gibt trotzdem nur ein 2D-Bild aus. Mit Geforce 3D Vision hat Nvidia die erste alltagstaugliche 3D-Brille im Programm. Mit 200 Euro für die Brille und knapp 300 Euro für einen TFT-Monitor mit 200 Hz kostet das System noch zu viel für den Massenmarkt. Einige Monitorhersteller forschen nach Lösungen, den 3D-Effekt ohne Brille zu realisieren. Uns zumindest wäre das lieber, als mit einer 3D-Brille auf der Nase zu spielen. In jedem Fall nimmt »Stereoscopic 3D« endlich wieder Fahrt auf, nachdem es jahrelang in der Versenkung verschwunden war. Wir können es kaum erwarten!

» DirectX 11, Raytracing & Co - Zukünftige Grafiktricks erklärt

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.