Wer sich im Bereich von Gaming und Film etwas umhört, wird schnell auf Aussagen wie diese treffen: »Unser Auge nimmt doch nur 30fps wahr, Kino ist ja auch flüssig!« Leider werden solche Aussagen immer ohne vernünftiges Hintergrundwissen getätigt. Deshalb würde ich gerne Vorurteile beiseite kehren, aufklären, sowie den Unterschied zwischen Spiel und Video erläutern und eine hoffentlich zufriedenstellende Antwort auf die Überschrift geben. Wobei die ersten Absätze über »fps« eher an Neulinge gerichtet sind.

Was ist dieses FPS?

An aller erster Stelle sollte jedoch einmal der Begriff »frames per second« erläutert werden.

Ein Videosignal besteht nämlich nur aus einzelnen Bildern (frames), durch das Hintereinanderschalten von ähnlichen Bildern entsteht die Intention einer Bewegung. 25fps bedeuten, dass wir 25 (unterschiedliche) Bilder jede Sekunde geliefert bekommen und ein Bild damit 40ms lang zu sehen ist.

Kinofilme laufen seit rund einem Jahrhundert mit 24fps (abgesehen von der Hobbit-Reihe) und werden mit 72Hz, bzw. 96Hz wiedergegeben (wobei hier ein Bild je 3, bzw. 4 Mal dargestellt wird). Für das deutsche Fernsehen wird das Videomaterial leicht beschleunigt um 25fps (»PAL«) zu erreichen. Einsteiger-TV-Geräte zeigen die Bilder doppelt an um auf 50Hz zu kommen, High-End-Geräte verwenden Motion Interpolation um extra Frames zwischen den gegebenen Bilder zu »erraten«, sie besitzen dafür ein Panel mit mindestens 100Hz. Spiele (zumindest auf dem PC) können theoretisch mit beliebig vielen Bildern pro Sekunde laufen, der Monitor beschränkt sich jedoch generell auf Frequenzen wie 60Hz oder 144Hz. Womit sich eine weitere Frage stellt…

Wieso ruckelt mein Spiel/Video, trotz fast 60 fps?

Schwankende Frametimes und Tearing können den Spielspaß natürlich mindern, wir beschränken uns jedoch lieber auf aktiviertes VSync. Deshalb nehme man einmal folgendes Szenario zur Hand: Unser Monitor läuft mit 60Hz, somit zeigt er im Idealfall 60 aufeinander folgende Bilder pro Sekunde an. Berechnet die Grafikkarte konstant 59fps in einem Spiel, muss je ein Bild einer Sekunde doppelt angezeigt werden (wegen VSync). Somit scheint der Ablauf kurz wie eingefroren, da ein Bild ungefähr 33,3ms lang und die anderen 58 Bilder je fast 16,7ms lang pro Sekunde gezeigt werden. Gleiches würde auch am TV passieren, wenn europäische Sender auf unverändertes 24fps Kinomaterial umstellen. Weitere Fälle und ausführliche Erklärungen finden sich im Artikel über VSync, FreeSync, FastSync, CPU/GPU Sync & mehr.

Generell kann also auch eine hohe Bildfrequenz von der Grafikeinheit stören, falls der Bildschirm nicht mit derselben oder einer vielfachen Frequenz arbeitet. In den folgenden Abschnitten wird der Verständlichkeit halber immer von einem passenden Monitor/Beamer ausgegangen.

Wieso ruckelt mein konstant 24fps Spiel mehr als Kinofilme?

Spielt man auf einem Röhrenmonitor oder übertaktet man sein durchschnittliches TN-Panel, kann man 72Hz einstellen. Da 72 ein vielfaches von 24 ist, wird auch jedes Bild eines PC-Spieles mit konstanten 24fps gleich lange dargestellt. Trotzdem ruckelt ein Real-Film deutlich unauffälliger.

Das liegt daran, dass für das Spiel jedes dieser 24 Bilder unabhängig voneinander erzeugt wird. Ein Einzelbild (ohne Post-Processing) also wie ein ruhiges Foto aussieht. Eine Kamera hingegen nimmt ihre Einzelbilder über ein paar Millisekunden auf, Bewegungen erhalten dadurch Motion Blur und erscheinen flüssiger. Aber Achtung, Bewegungsunschärfe-Optionen in Spielen tricksen oftmals unschön und sind dann keine echte Konkurrenz. Wobei man sich auch fragen sollte ob man das überhaupt will, es entsteht nämlich sowieso Unschärfe durch die Reaktionszeit des Monitors und durch etwas namens Persistence of Vision (mehr dazu in Teil 3). Je niedriger die Response-Time und diese Persistence, desto mehr Schärfe und das will man doch schließlich.

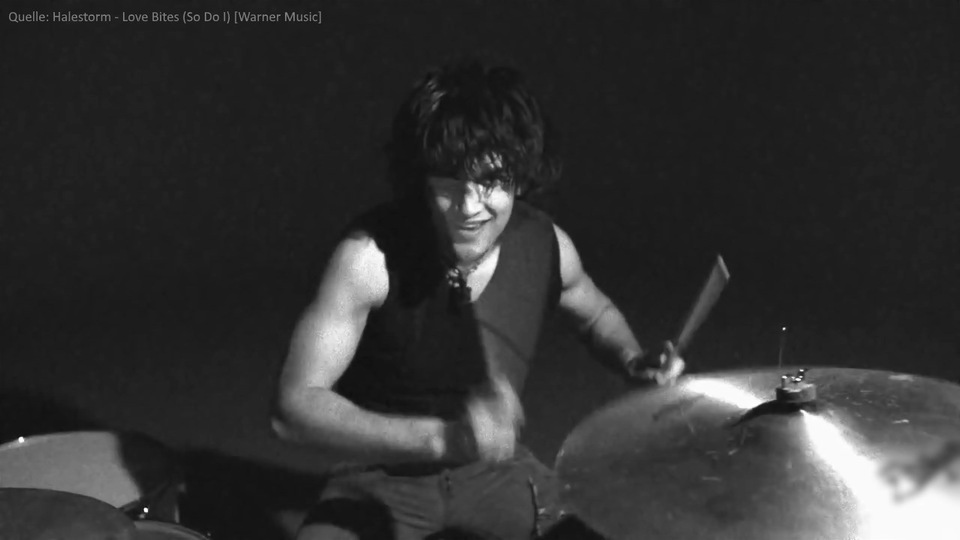

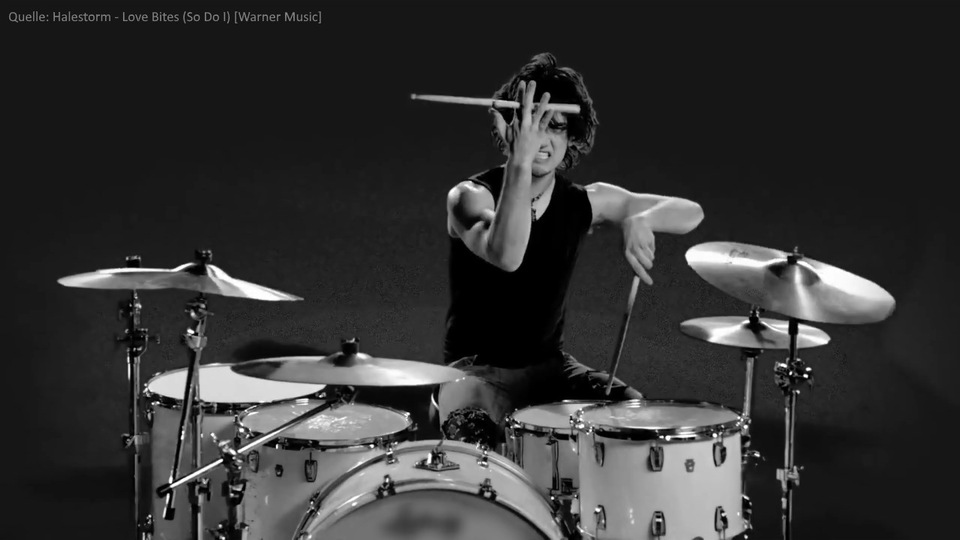

Drummer Arejay Hale: Motion Blur besonders sichtbar an den Sticks

Ist denn Motion Blur jetzt gut oder schlecht?

Es gibt kein Gut oder Böse. Den Vorteil bei 24fps haben wir schon geklärt. Nachteil, was uns auch schon der Name spoilert, ist die unschöne Unschärfe. Wollen wir uns in einem Actionfilm auf die schwingenden Fäuste fokussieren, verwischen diese ins Unerkenntliche, sobald sie sich bewegen, da bei 24fps sehr schnell, sehr starke Bewegungsunschärfe auftritt.

Seufz. Wäre echt cool, wenn man etwas dagegen tun könnte. Ah! Aber na klar, wie wäre es mit einer höheren Bildrate. Zeichnet man etwas mit beispielsweise 48fps auf, erhält man nicht nur ein flüssigeres Bild, sondern es gelingt zusätzlich mehr Bewegungsschärfe. Tada!

High-Speed-Kamera: Neben glatteren Bildwechseln gewinnen Bewegungen an schärfe, je mehr Frames aufgezeichnet werden.

Dann sind 30fps doch nicht genug?

Genau, entweder ruckelt das Bild zu stark oder Translokationen werden zu stark weichgezeichnet. Des Weiteren verringert sich die Latenz bei Games, umso höher die Bildfrequenz wird. Kann jedes Bild bei 30 fps bis zu 33,¯3 ms alt werden (ohne Beachtung weiterer Latenzen), sind es bei 144 fps auf einem Monitor mit 144 Hz nicht einmal 7 ms. Für CS:GO-Sportler ein durchaus kräftiges Argument.

Aber wo liegt denn dann die Grenze, wenn nicht bei 30fps?

Vielleicht sollten wir am unteren Ende beginnen. 24 hintereinander aufgezeichnete Bilder pro Sekunde lassen sich als Zusammenhängend interpretieren. Mehr natürlich auch, aber wo liegt die untere Grenze?

Wir schalten unseren Monitor eine Stunde lang aus, so haben wir ein 1-fph-Schwarzbild. Nun, dies ist wohl etwas passiv, aber für eine Zeitspanne ohne Bewegung genügen mindestens 0 fps. Logisch. So starten wir lieber das gute alte Snake, pro Zeitspanne bewegt sich hier die Schlange um einen Pixel (Kantenglättung gab es damals noch nicht). Wenn sie sich also in ihrer kurzen Form noch langsam bewegt, sagen wir alle 1 Sekunde, muss auch nur 1 fps geliefert werden um flüssig zu wirken. Bei gefilmten Material (somit inklusive Motion Blur) mit vernünftigen Bewegungen liegt jedoch die Interpretationsschwelle bei ca. 16 bis 18 Bildern die Sekunde.

Trotzdem, wegen der Unterteilung in Pixel kann eine sehr langsame Bewegung auch noch mit 10 fps flüssig wirken. Doch bringt dies uns letztlich in vielen Spielen recht wenig, da die meisten Genres nur von ihren dauerhaften Kameraschwenks leben, so können hingegen Filme mit oftmals statischen Kameraperspektiven ab und an vollkommen zufriedenstellen. Die Frage nach »Wie viel fps sind flüssig?« liefert also nicht unbedingt eine Antwort auf die Framegrenze des Auges.

Snake: Einer langsamen Schlange genügen weniger Frames als einer schnellen um beide flüssig zu sehen.

Nicht schlapp machen, wie hoch muss die Bildrate jetzt sein, damit es mit der Frequenz des Auge übereinstimmt?

Weder 24, 30, 75, noch 144 Hertz.

Wurde das Browserfenster nicht beleidigt geschlossen, hilft vielleicht ein Experiment beim Messen der »Augenfrequenz«. Schaut man in ein Licht, dass für einen Augenblick aus und wieder angeschaltet wird, erkennt man die Zustandswechsel bei einem Aussetzen des Lichtes ab einer Zehntel Sekunde. Wenn das Licht kürzer aussetzt, würde man es nicht merken. Deshalb läuft ja ein Film im Kino auf einem Projektor mit mindestens 72Hz, da das Bild für einen Sekundenbruchteil Schwarz werden muss, solange der nächste Frame vorbereitet wird.

Gut, das war's also, unser Auge sieht mit 72 fps, basta.

Halt! Selbst bei einem Blindtest kann man noch zwischen 72 fps und 144 fps auf einem passenden Panel einen Unterschied ausmachen. Zudem scheint dieser Versuch die Definition von Bewegung zu überstrapazieren. Das Auge, so gut es auch ist, ist einfach zu faul um diese Art der Umgebungsänderung aufzuzeichnen. Das gegenteilige Experiment (also ein Lichtblitz im Dunkeln) zeigt nochmals, dass Bewegung nicht immer gleich Bewegung ist: Leuchtet etwas für 4 oder 5 Millisekunden in der Dunkelheit kann man es noch gerade so mitbekommen. Hier ist das Auge also empfindlicher.

Neues Minimum für maximale Flüssigkeit ist also ca. 200 fps. Andernfalls könnte unser Spiel mit 60 fps, welches nun mal nur alle 16,¯6 ms ein Bild berechnet, dieses aufblitzen verpassen oder gar einen ganzen Frame lang anzeigen und damit deutlich länger als beabsichtigt.

Und was macht dann unser Auge, um immer die passende Bildrate zu finden?

Unser Auge aktualisiert nicht den ganzen Sehbereich mit einer bestimmten Frequenz. Verschiedene Rezeptoren im Auge arbeiten unterschiedlich schnell oder unterschiedlich gründlich, und sind für verschiedene Sichtänderungen konzipiert. So unterscheidet sich neben der Sensitivität auf hell und dunkel auch die Empfindlichkeit für diverse Farben.

Wenn Rezeptor Fritzchen mit x Hertz ein Signal übermittelt, könnte das Gehirn zusammen mit Zellennachbar Hansi eine Frequenz größer x Hertz erreichen. Darüber hinaus wertet das Gehirn weitere Faktoren hinzu, wie das Räumlichkeitsempfinden durch das anderes Auge, Kopf- und Körperbewegungen mithilfe der Ohren, den Fokus der Linsen, usw.

Ein simuliertes Kamerawippen in Ego-Perspektive wird immer fremd wirken (außer in der Matrix). Genauso wie einzelne Bilder, die wir uns zu einer übergangslosen Bewegung zusammendenken. Und niemand würde alle paar Sekunden eines Filmes ungefähr 3 Bilder einschwärzen um den Wimpernschlag zu simulieren.

Theoretisch gibt es trotzdem eine Grenze, ab der eine Translokation von Pixeln bei einer bestimmten Framerate nicht mehr von der Realität unterscheidbar sein könnte. Wenn wir uns nochmals Snake widmen und sagen, bei 60 Hz bewegt sich die Schlange um 60 Pixel pro Sekunde, bei 120 Hz um 120 Pixel, und immer so weiter. Gibt es dann eine Frequenz bei der unser Auge uns vormacht, die Schlange überspringe Pixel? Bei 1000 fps? 60000 fps? Und macht die Größe der Pixel einen Unterschied, würde ein SnakeHD nicht von feineren Pixeln profitieren?

Gibt es dann vielleicht nicht auch in Zukunft eine bessere Technik um unsere Augen »auszutricksen«? Denn beim Schwenken des Blickes spielt die eigentliche Bewegung kaum eine Rolle, man konzentriert sich nur auf das Ziel am Ende der Regung und nicht auf die Geste an sich.

https://www.youtube.com/watch?v=KsTBfYWI3t8

GameStar-News: Auch ohne 60fps unterhaltsam. (Aber in den Kommentaren steht viel Quatsch über fps und das Auge)

Hätte man das nicht gleich sagen können?

Hätte, hätte, Fahrradkette, ich hoffe nur, dass sich nicht so viele Leute gegen längst überfällige Änderungen wehren und bei einer Erhöhung der Bildrate nicht schreien: »Man sieht doch eh keine Unterschied, Werbelüge!« oder »Der Filmflair geht verloren, ist ja fast so schlimm wie Farbfernsehen!«. Man sollte allgemein immer Offenheit besitzen wenn es neue Verbesserungen für wenig Mehraufwand gibt, egal bei welchem Thema.

Kommt man selbst nicht sofort damit zurecht, wird es dagegen für nachfolgende Generationen, die mit 48/60-fps-Filmen oder 288-Hz-Bilschirmen groß werden, merklich angenehmer und natürlicher sein.

Speziell bei Filmen ist die Eingewöhnungszeit durchschnittlich sehr kurz und man nimmt Videos deutlich bekömmlicher wahr, da einem die Bildsequenz wesentlich flüssiger vorkommt.

Persönlich bevorzuge ich daher 60+ fps in Spielen, statt Ultra-Einstellungen und Mega-Antialising. Wie auch Motion Interpolation trotz der ab und an sichtbaren Artefakte. Wobei beides letztlich Geschmackssache ist.

Gibt es eigentlich für den Quatsch der hier erzählt wurde irgendwelche Nachweise?

Sehr wichtig, durch die zwei Quellen bin ich überhaupt erst zu dem Wissen gekommen:

- Dieser Blogbeitrag ist Teil 1 von 2 in der Serie Mit welcher Refreshrate und Auflösung sieht unser Auge?.

- Favorisiert

Wie viele Bilder pro Sekunde sieht unser Auge?

Kategorien:

- Dieser Blogbeitrag ist Teil 1 von 2 in der Serie Mit welcher Refreshrate und Auflösung sieht unser Auge?.

![[IMG]](https://upload.wikimedia.org/wikipedia/de/thumb/0/04/Snake_trs-80.jpg/640px-Snake_trs-80.jpg)

Kommentare

Kommentare sortieren nach