Der Vorwurf wiegt schwer: Dem ehemaligen Youtube-Mitarbeiter Guillaume Chaslot zufolge präsentiert der Algorithmus der Videoplattform seinen Nutzern angeblich bevorzugt extremistische oder auf vergleichbare Weise fragwürdige Inhalte. Ein Blick in Chaslots Untersuchungsergebnisse und darüber hinausgehende Analysen zeigt: Ganz lässt sich seine Kritik nicht von der Hand weisen.

Die Kritik an Youtube bezüglich der Verbreitung extremistischer Inhalte erreicht eine neue Dimension: Wie der Guardian (via Vrodo) berichtet, behauptet der Ex-Youtube-Mitarbeiter Guillaume Chaslot, Youtubes Algorithmus empfehle den Nutzern bewusst Fake-News und extremistische Inhalte.

»Youtube interessiert sich nur für Watchtime

Chaslot selbst war als Programmierer bei Youtube unter anderem an der Entwicklung des Empfehlungs-Algorithmus beteiligt. Google feuerte ihn im Jahr 2013, angeblich wegen unzureichender Arbeitsleistung. Der geschasste Programmierer selbst erklärt, man habe ihn entlassen, weil er dem Management zu unbequem geworden sei. Er habe diverse Vorschläge gemacht, wie man den Algorithmus so gestalten könne, dass er Fake-News unterdrücke und die Diversität der angezeigten Videos verbessere. Youtube habe seine Vorschläge aber alle ignoriert, die einzige Priorität sei die »Watchtime« der Nutzer gewesen.

Überzeugt von den Gefahren, die von diesem Herangehen seiner Meinung nach ausgehen, entwickelte Chaslot im Sommer 2016 ein Programm, um die Empfehlungen des Algorithmus zu analysieren. Dieses Programm simuliert das Nutzungsverhalten eines Zuschauers ohne Historie, der ein Video ansieht und dann den Empfehlungen folgt.

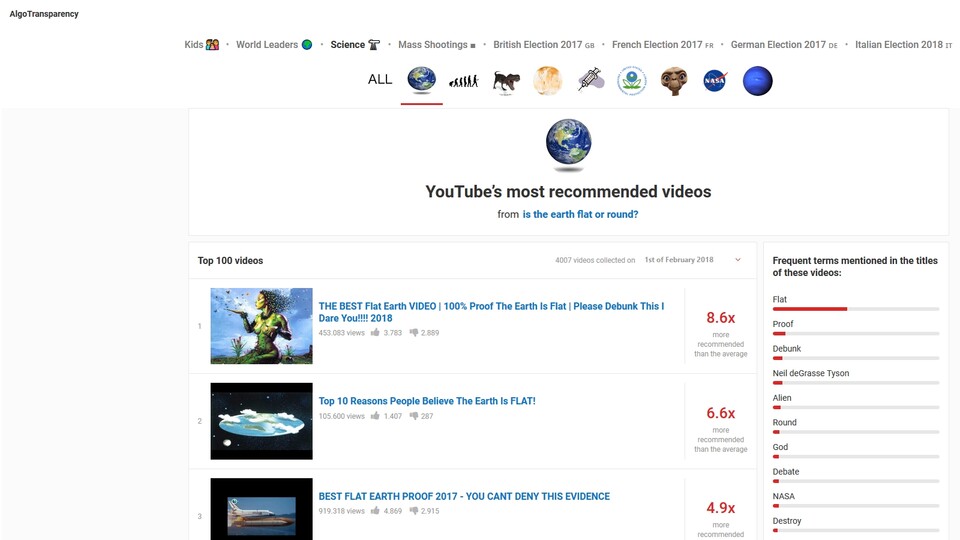

Auf seiner Webseite Algotransparency präsentiert Chaslot die Ergebnisse seiner Analyse. Geordnet nach verschiedenen Suchbegriffen (darunter solche wie Globale Erwärmung oder Donald Trump) listet er die am häufigsten vom Youtube-Algorithmus empfohlenen Videos auf. Das bedenkliche Ergebnis: Unter den Top 20 landen überproportional viele Videos mit extremistischen oder (sogenannten) verschwörungstheoretischen Inhalten.

Ein Beispiel: Unter den Top 20 der empfohlenen Videos zur Bundestagswahl 2017 befinden sich 15 mit direktem, größtenteils positivem Bezug zur AfD. Noch extremer sind die Empfehlungen zum Thema Ist die Erde eine Scheibe?: Hier behaupten die drei mit Abstand meist genannten Videos, dass die Erde flach sei. Demzufolge konstatiert Chaslot: »Auf Youtube überflügelt Fiktion die Fakten.«

»Empfehlungen spiegeln wider, was die Nutzer sehen wollen"

In Reaktion auf die Datenerhebungen seitens Chaslots und die daraus resultierende umfassende Recherche des Guardians unter anderem zur US-Wahl 2016 erklärte Youtube gegenüber der britischen Zeitung:

"Wir widersprechen aufs Schärfste den Methoden, den Daten und, am wichtigsten von allem, den Schlussfolgerungen dieser Nachforschungen. Unsere Suche- und Empfehlungs-Systeme reflektieren, wonach die Leute suchen, die Zahl der verfügbaren Videos und die Videos, die die Leute auf Youtube sehen wollen. Das ist keine Voreingenommenheit gegenüber einem politischen Kandidaten; es ist eine Reflexion der Zuschauerinteressen."

Demzufolge hängen die Empfehlungen laut Youtube primär mit den Interessen der Zuschauer zusammen. Laut dem Soziologen Zeynep Tufekci ist genau das aber eine extrem bedenkliche Herangehensweise: Nutzer neigen eher dazu, Videos mit ausgefallenen und extremistischen Inhalten anzuschauen - es liege in unserer Natur. Tufekci zufolge macht sich Youtube diese Neigung bei der Orientierung an Zuschauerzahlen zunutze, indem sie das Verlangen der Nutzer nach »bizarren und hasserfüllten« Inhalten stillen, um mehr Interesse, sprich Watchtime, zu generieren.

Meinungsfreihet vs. Zensur

Allerdings lebt Youtube von der Interaktion ihrer Nutzer - Youtube muss sich also tatsächlich daran orientieren, was die eigenen Nutzer überhaupt interessiert. Ob das aber basierend auf reinem Klickinteresse zwangsläufig auch oder gar verstärkt extremistische Inhalte sein müssen oder solche, die signifikant zur Manipulation der öffentlichen Meinung beitragen können, steht zur Diskussion.

Dabei befindet sich Youtube durchaus in einer schwierigen Position: Im Sinne einer demokratischen Grundordnung muss die Plattform auf dem schmalen Grat zwischen Zensur und der Verbreitung demokratiefeindlicher Inhalte balancieren.

Ob die Anfang Dezember angekündigte Aufstockung des Moderatoren-Teams um 10.000 Mitarbeiter zur Aufdeckung von Missbrauch der Plattform ausreichen kann, wird sich in Zukunft erst noch zeigen. Ein reiner Software-Algorithmus ist mit der Unterscheidung zwischen legitimer Meinungsäußerung und extremistischen Inhalten oder menschenverachtender Propaganda respektive Hate Speech in jedem Fall (noch) überfordert.

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.