In den vergangenen Wochen gab es eine rege Diskussion über den Einsatz von KIs bei wissenschaftlichen Studien. Auch das Magazin 404Media berichtete am 18. März 2024 über fragwürdige ChatGPT-Phrasen bei renommierteren Publishern.

Natürlich sollen künstliche Intelligenzen unseren Alltag erleichtern – doch welchen Schaden richten sie an, wenn sie offenkundig ungeprüft in wissenschaftlichen Arbeiten und Studien eingesetzt werden? Eine Spurensuche.

Warum KI-generierte Texte in Studien ein Problem sind

Künstliche Intelligenzen sind größtenteils dazu entwickelt worden, unseren Alltag zu unterstützen. ChatGPT kann uns beispielsweise E-Mail-Texte verfassen. Allerdings gibt es auch die Möglichkeit der KI folgende Aufgabe zu geben: Schreibe mir eine wissenschaftliche Studie über Regenwürmer

.

Die KI bedient sich dann aus bestehenden Quellen aus dem Internet oder ihrer erlernten Datenbank – sie kann also kein neues Wissen im klassischen Forschungs-Sinne generieren oder eigene Forschung betreiben. Die KI gibt also nur bereits bestehendes oder erlerntes Wissen wieder.

Mit anderen Worten ist es fremdes, geklautes Wissen und kann potentiell Fehler enthalten.

Laut dem Magazin 404Media gehen auf Twitter zu diesem Thema aktuell mehrere X-Postings (ehemals Twitter) viral, die diesen Zustand kritisieren:

Link zum Twitter-Inhalt

So schreibt die Verfasserin dieses Posts:

Es kommt noch schlimmer. Wenn man bei Google Scholar nach "Stand meiner letzten Wissensaktualisierung" oder "Ich habe keinen Zugang zu Echtzeitdaten" sucht, tauchen tonnenweise KI-generierte Arbeiten auf.

Wir haben es ebenfalls getestet. Bei Google Scholar bekommen wir rund 188 Ergebnisse, die den Satz As of my last knowledge update

beinhalten. Das ist eine typische ChatGPT-Phrase, die dem Nutzer klar machen soll, wo sich die Wissensgrenze der KI befindet.

Wichtig: Wir konnten bei der entsprechenden Studienzahl zeitlich nicht überprüfen, ob es sich tatsächlich um generierte Inhalte handelt. Allerdings finden sich allein bei Google Scholar über 170 Studien, die mit der klassischen KI-Phrase nach 2020 publiziert wurden.

Man kann also mit einer hohen Wahrscheinlichkeit davon ausgehen, dass zumindest Teilabschnitte mit den entsprechenden Formulierungen KI-unterstützt generiert wurden.

Als Einschränkung gilt dabei: Einige Studien handeln selbst über KI und eben jene Formulierungshilfen. Auf der anderen Seite kann auch vermutet werden, dass die Dunkelziffer deutlich höher liegen wird. Die entsprechende KI-Phrasen-Spur kann natürlich nachträglich verwischt werden.

Die Mühe scheinen sich viele Autoren wie Publizisten allerdings nicht einmal zu machen. Ein weiteres Twitter-Beispiel führte 404Media hiermit auf:

Link zum Twitter-Inhalt

Hier ist eine mögliche Einleitung zu deinem Thema

steht hier als KI-Satz sogar direkt am Anfang der veröffentlichten Studie.

Das Problem: Laut 404Media handelt es sich oft um kleinere Paper Mills

, also Zeitschriften mit niedrigem redaktionellem Standard. Dort wird teilweise gegen Geld eine schnelle Publikation versprochen und der Inhalt wenig bis gar nicht geprüft.

Aber auch große Magazine wie das renommierte Nature

kämpfen gegen die Flut an Schein-Studien. Laut ihren Aussagen wurden allein 2023 etwa 10.000 Studien zurückgezogen oder abgewiesen.

So könnt ihr eine Studie mit drei einfachen Tricks überprüfen

Natürlich sind KI-Phrasen nicht der einzige Hinweis auf eine fehlerhafte Studie. Falls ihr genaue Quellen für eure eigene wissenschaftliche Arbeit, ein Referat oder ähnliches braucht oder nicht sicher seid, ob ihr dem Geschriebenen einer Studie vertrauen könnt, gibt es drei einfache Tricks:

Trick 1: Sample Size prüfen

Sample Size meint die Anzahl an Studienteilnehmer. Je mehr Patienten beispielsweise an einer klinischen Prüfung teilgenommen haben, desto akkurater lässt sich ein Ergebnis festlegen. Meist lässt sich diese Zahl im Abschnitt der Ergebnisse ablesen.

Wenn ihr also in den Ergebnissen einer Studie lest, dass lediglich 8 Patienten einen neuen Inhalator getestet haben, ist die Aussagekraft logischerweise niedriger als bei einer Sample Size von 400 oder mehr.

Trick 2: Wie hoch ist der Impact-Faktor des publizierenden Mediums?

Wichtig: Der Impact-Faktor (IF) ist kein direktes Qualitätsmerkmal. Die Zahl sagt aus, wie oft die Artikel und Publikationen eines Mediums in anderen wissenschaftlichen Publikationen pro Jahr zitiert werden.

In der Praxis wird der IF allerdings oft von Regierungen, Bibliotheken oder Hochschulen zur Einschätzung des Mediums verwendet. In der Regel reicht es, wenn ihr zum Beispiel Impact-Factor Nature Magazin

googelt. Die Faustformel: Je höher der Wert, desto besser. Werte über 10 gelten als herausragend.

Für Interessierte: Eine genauere Anleitung hat das Helmholz-Institut veröffentlicht.

Trick 3: Hirsch-Faktor der Autoren prüfen

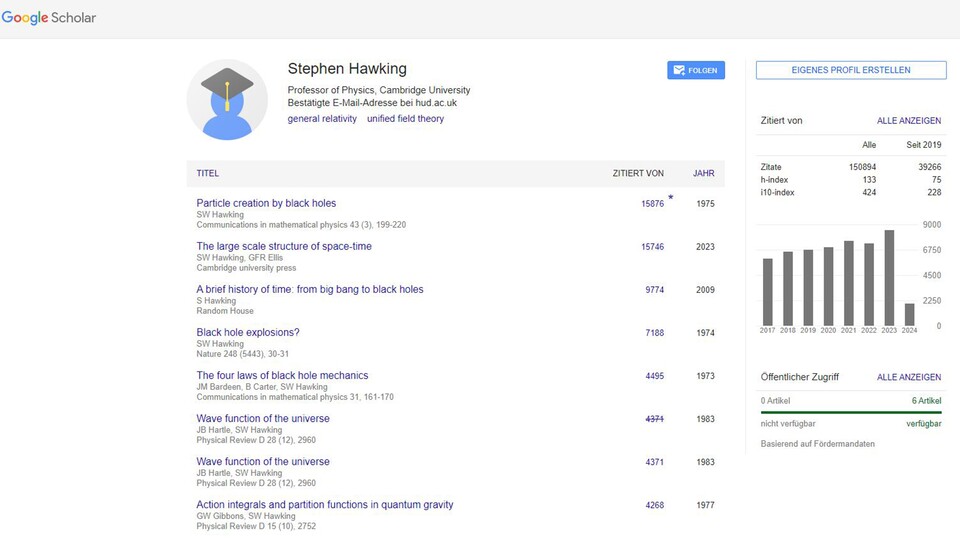

Der Hirsch-Faktor oder -Index sagt ähnlich zum Impact-Faktor für Medien aus, wie oft ein Autor in einer weiteren wissenschaftlichen Arbeit rezitiert wurde. Ein hoher H-Index bedeutet also, dass der Autor von vielen Wissenschaftlern als vertrauenswürdige Quelle eingestuft wurde und die Arbeiten des Autors deshalb oft rezitiert werden. So sieht das aus:

So geht's: Geht dafür auf Google Scholar. Hier könnt ihr im Suchfeld nach dem Wissenschaftler suchen, zum Beispiel Stephen Hawking. Klickt dann auf das Profil. Dann sollte euch Google Scholar Daten über die genaue Anzahl der Rezitationen geben sowie den H-Index auf der rechten Seite.

Natürlich sind das ebenfalls nur ein paar Strohhalme der Sicherheit. Vor Fälschungen ist man leider nie ganz gefeit. Doch mit den richtigen Tricks, können wir immerhin ein wenig dagegen vorgehen.

Sind euch schon ähnliche Missstände aufgefallen? Kennt ihr weitere Tricks zur Einordnung von Studien? Dann schreibt sie gerne in die Kommentare.

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.