Vor einigen Jahren gab es noch die Befürchtung, dass das Integrieren von Grafikkernen in Prozessoren letztlich dazu führen könnte, dass Grafikkarten ersetzt werden. Auf der GPU Technology Conference in Peking hat Nvidia-CEO Jensen Huang laut Segment Next den Spieß umgedreht und angekündigt, dass Grafik-Prozessoren bald die herkömmliche, klassische CPU ablösen werden.

Das Mooresche Gesetz, das bei Prozessoren vorhersagt, dass sich die Anzahl der Transistoren und damit die Leistung bei CPUs in bestimmten Abständen verdoppelt, gelte für normale Prozessoren schon seit Jahren nicht mehr, so Huang.

Das Mooresche Gesetz ist nicht mehr relevant

Dieses »Gesetz«, das schon immer eher eine Statistik war, die in die Zukunft interpoliert wurde, ist laut Huang nicht mehr relevant und bei CPUs habe es pro Jahr zuletzt nur noch Leistungssteigerungen um 10 Prozent gegeben. Gelegentlich sei aber die Anzahl der verbauten Transistoren um 50 Prozent gesteigert worden.

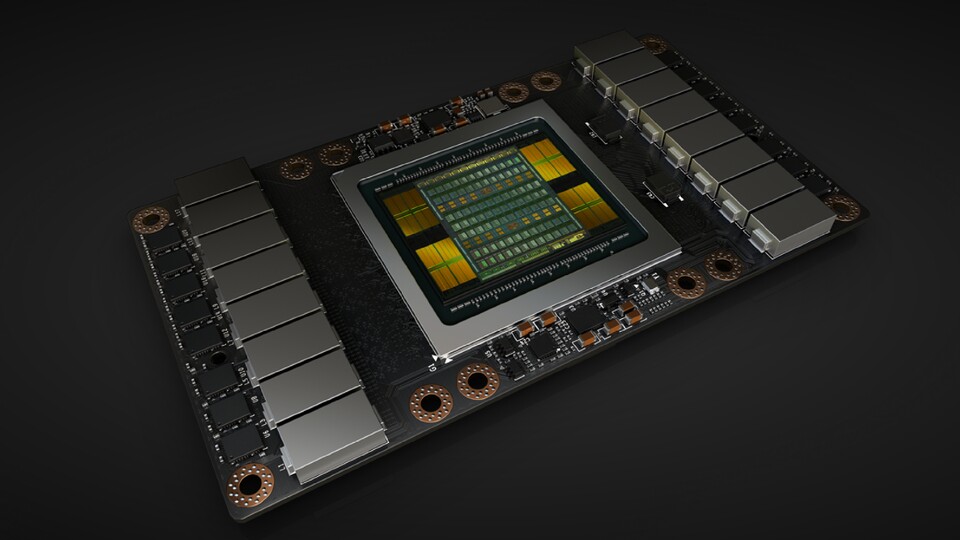

Für Grafik-Prozessoren habe das Gesetz ebenfalls schon länger nicht mehr gegolten, da hier die Entwicklung ganz anders verläuft als bei klassischen Prozessoren. Die Fähigkeiten von Grafikchips bei parallelen Berechnungen und in Bereichen wie neuralen Netzwerken würden sogar schneller gesteigert, als es das Mooresche Gesetz erwartet.

GPUs perfekt für parallele Berechnungen

GPUs seien perfekt für KI-Anwendungen, während es bei den CPU-Entwicklern Probleme gäbe, eine Lösung für die parallele Verarbeitung von Befehlen zu finden. Gerade das werde aber in Zukunft immer wichtiger.

Das sieht sogar Intel ähnlich, denn dort entwickelt man gerade einen Spezialchip namens Loihi, der interne Verbindungen nach dem Vorbild des menschlichen Gehirns besitzt und auf ähnliche Weise lernen soll. Die Energieeffizienz sei um den Faktor 1.000 besser als bei Systemen, die für allgemeine Aufgaben gedacht sind – und dann wäre das Mooresche Gesetz wohl doch noch für einige Zeit gültig.

5:12

Nvidia Geforce GTX 1080 Ti im Test - Spielebenchmarks der 4K-Grafikkarte

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.