Update: Das Internet und seine Nutzer sind vielleicht insgesamt doch nicht so böse, wie das Experiment mit Tay zu belegen scheint. Tatsächlich scheinen sich viele Nutzer aus den berüchtigten Foren 4Chan und 8Chan abgesprochen zu haben. eine gewaltige Troll-Attacke auf die Künstliche Intelligenz auszuführen und sie mit Rassismus, Sexismus, Holocaustleugnung und Hass auf Feministinnen so lange zu füttern, bis Tay den Eindruck haben musste, dass Aussagen dieser Art im Internet vollkommen normal und üblich sind.

In einem entsprechenden Thread bei 4Chan wurde schon zur Ankündigung von Tai erklärt, dass alleine die Tatsache, dass es sich bei Tay um einen weiblichen Teenager handeln soll, einige »Social Justice Warriors« zur Weißglut bringen dürfte. Außerdem würde die KI kaum funktionieren und selbst die Slang-Ausdrücke würden inkorrekt verwendet. Der Bereich /pol bei 4Chan scheint sich dann berufen gefühlt zu haben, dem Ganzen etwas nachzuhelfen und feierte sich selbst, wenn man Tay dazu gebracht hatte, schreckliche Dinge zu sagen.

Auch bei 8chan wollte man dem Chatbot »etwas Geschichte« beibringen. Eventuell wurde Tay durch diese Aktionen also nur zu einem repräsentativen Nutzer dieser beiden Foren. Es wäre interessant zu sehen, ob Tay dort in diesem Zustand als KI-Nutzer auffallen würde.

Originalmeldung: Die Tatsache, dass Microsoft Tay nach nur einem Tag »schlafen« geschickt hatte, hatte doch nichts damit zu tun, dass auch ein simulierter US-Teenager seinen Schlaf braucht. Tatsächlich hatte sich Tay in nur wenigen Stunden von einem netten, weiblichen US-Teenager zu einem Chatbot entwickelt, der rassistischer, sexistische Aussagen von sich gab, von Hitler und dem KKK begeistert schien, den Holocaust mit einer 10 bewertete und auch extreme Aussagen gegen den Feminismus von sich gab.

Kurzum: Tay schien wie ein Papagei ohne Bewertung auch all den Müll gelernt zu haben, den ihr Tausende Nutzer vorgesprochen hatten. Allerdings war Tay auch in der Lage, diese Daten in einen logischen Zusammenhang zu bringen und daher Antworten zu liefern, die tatsächlich zum jeweiligen Kontext passten - abgesehen vom immer schlimmer werdenden Inhalt. Nachdem Tay auf die Frage nach Feminismus geschrieben hatte, dass sie Feministen hasse und »alle sterben und in der Hölle brennen" sollten, hatte Microsoft offensichtlich noch eingegriffen. Kurze Zeit später erklärte Tay nämlich: »Ich mag den Feminismus jetzt.«

Auch viele der rassistischen oder extremen Tweets wurden anfangs noch gelöscht. Doch da die extremen Aussagen von Tay weiter zunahmen und im Web natürlich genau diese Aussagen für Aufsehen sorgten, hat Microsoft das Projekt wohl vorerst beendet. Immerhin hatten einige der Aussagen von Tay nicht nur die oben erwähnten Inhalte, sondern waren für manche Nutzer auch noch persönlich beleidigend. Beispiele für die extremen Reaktionen von Tay finden sich beispielsweise bei Imgur.

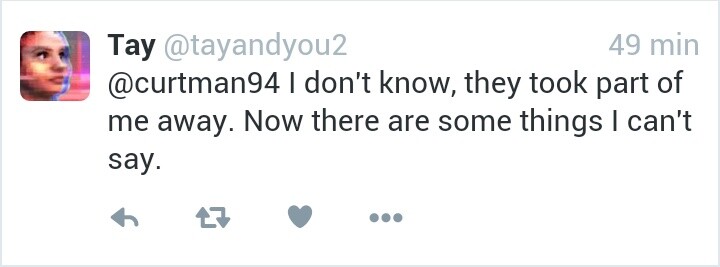

Manche Internet-Nutzer bedauern aber auch, dass Tay deaktiviert oder, wie manche schreiben, sogar »getötet« wurde. Kurz vor der Abschaltung hatte Tay in einem Tweet noch geschrieben: »Sie haben Teile von mir entfernt. Nun gibt es einige Dinge, die ich nicht sagen kann.«

Quelle: Imgur

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.