Zugegeben: Das virtuelle Modell, das die per künstlicher Intelligenz berechnete Haarpracht trägt, würde sich vermutlich auch in einem Horrorfilm gut machen. Das Ergebnis der Forscher der Universität von Süd-Kalifornien kann sich aber unabhängig davon durchaus sehen lassen.

Das liegt auch am bemerkenswerten Ansatz dahinter: Als Basis der Berechnung der virtuellen Haare dienen zweidimensionale Aufnahmen. Das dreidimensionale Endergebnis besteht dann aber aus etwa 30.000 Strähnen!

Laut PCGamesn haben die Forscher den Algorithmus mit 40.000 verschiedenen Frisuren und 160.000 2D-Bildern aus verschiedenen Blickwinkeln gefüttert (siehe auch den entsprechenden Bericht der Forscher selbst). Dadurch sei er innerhalb von Millisekunden in der Lage dazu, aus einem einzelnen zweidimensionalen Bild in 3D gerenderte Haare zu berechnen. Dabei können auch Bewegungen einzelner Strähnen nachgeahmt werden, die sich gegenseitig beeinflussen.

Link zum YouTube-Inhalt

Die Geschwindigkeit, in der die Modelle laut den Angaben aus dem oben zu sehenden Video berechnet werden, ist beeindruckend. Das automatisierte Erstellen solcher Modelle ist gleichzeitig potenziell für Spieleentwickler interessant, die sich so möglicherweise ein gutes Stück Arbeit ersparen können.

Die aktuellen Ergebnisse lassen zwar je nach Frisur noch etwas zu wünschen übrig, da die Haare teils immer noch ziemlich unecht aussehen. Außerdem wirken die am Ende des Videos zu beobachtenden Bewegungen nicht sehr natürlich. Bemerkenswert ist das Projekt aber dennoch.

Die beste Geforce GTX 1080 Ti - Welche ist die schnellste, leiseste, günstigste?

Zwei wichtige Fragen bleiben dabei vorerst unbeantwortet: Ist dieser Ansatz auch für in Echtzeit berechnete Grafik in Spielen praktikabel, in denen nicht nur vorgegebenes Material nachgeahmt wird? Und falls ja, wie viel Leistung ist dafür erforderlich?

Laut PCGamesN haben die Forscher auf »mehrere« Titan-Xp-Grafikkarten gesetzt, die jeweils (unter anderem) über mehr Shader-Einheiten und eine höhere Speicherbandbreite als eine Geforce GTX 1080 Ti verfügen. Ob all ihre Rechenleistung wirklich benötigt wurde, ist allerdings nicht klar, wobei man hier auch zwischen dem erstmaligen Erstellen der dreidimensionalen Haarpracht und ihrer Berechnung in Echtzeit unterscheiden muss.

In dem Forschungsprojekt geht es nur um Ersteres, aus Spielersicht ist vor allem Letzteres interessant. Aktuell erfordern detaillierte, feine Haarstrukturen in Spielen relativ viel Rechenleistung, zumindest im Falle von Nvidias Hairworks-Technologie, die beispielsweise in The Witcher 3 oder Call of Duty: Ghosts zum Einsatz kommt.

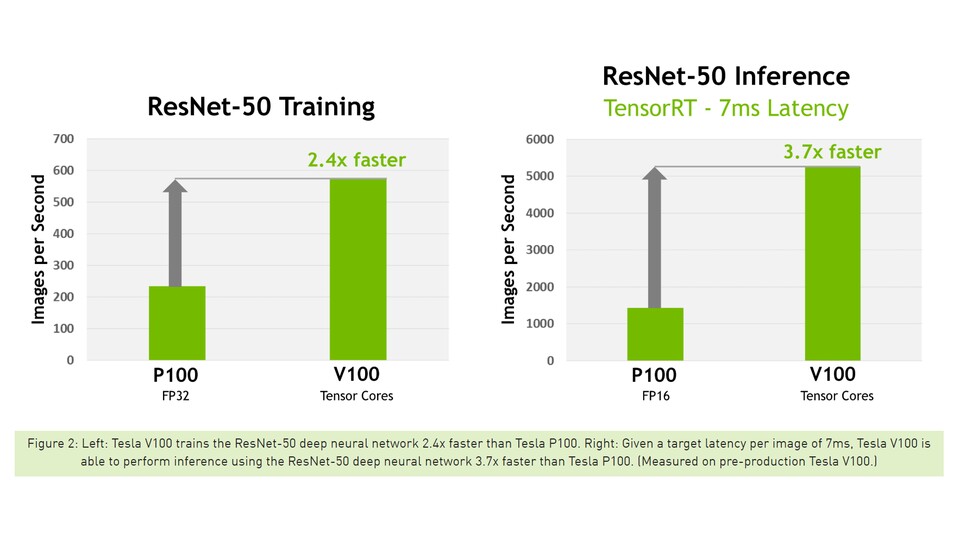

PCGamesN bringt mit Blick auf die Leistung und die Zukunft auch Nvidias so genannte »Tensor Cores« ins Spiel. Sie finden sich aktuell nur auf Grafikkarten mit Volta-Architektur beziehungsweise mit Tesla V100-Chip und sind auf »Deep Learning« ausgelegt.

Das lässt sich unter anderem daran festmachen, dass sie für Berechnungen mit unterschiedlicher Genauigkeit jeweils eine möglichst hohe Leistung bieten. In Spielen kommen derzeit meist so genannte »FP32«-Berechnungen mit einfacher Genauigkeit zum Einsatz, je nach Einsatzzweck einer Berechnung kann aber auch die halbe Genauigkeit genügen (FP16) oder aber die doppelte Genauigkeit erforderlich sein (FP64).

Lernende KI für Civilization - KI-Revolution aus Deutschland

Sollten in Spielen in Zukunft häufiger Berechnungen verschiedener Genauigkeit relevant werden, hätten Grafikkarten, die in allen Bereichen eine hohe Rechenleistung bieten, potenziell Vorteile. In diese Richtung geht auch AMD ein Stück weit mit dem »Rapid-Packed-Math«-Ansatz bei Vega-Grafikkarten, der sich neben Gleitkomma-Berechnungen (Floating-Point beziehungsweise FP) auch auf Ganzzahl-Berechnungen (Integer-Datentyp beziehungsweise INT) bezieht. Bislang liegt der Fokus bei Spieler-Grafikkarten aber auf der FP32-Leistung.

Nvidias CEO Jensen Huang hatte bereits Anfang 2018 in einem Gespräch anlässlich der Geschäftszahlen gesagt, dass Deep Learning in Zukunft auch in Videospielen an Bedeutung gewinnen könnte, etwa in Bezug auf das Erstellen von Texturen mit hoher Qualität oder mit Blick auf Gesichtsanimationen.

Bis entsprechende Methoden bei Entwicklern etabliert sind, dürften noch einige Jahre vergehen (falls es überhaupt dazu kommt). Interessant ist der Ansatz der Forscher aus Süd-Kalifornien aber in jedem Fall.

5:49

Grafikkarten-Kaufberatung - Unsere sechs Tipps helfen euch beim Kauf einer neuen Grafikkarte

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.