Wenn es heutzutage um das Thema Grafikkarten geht, werden schnell Begriffe wie Raytracing oder DLSS genannt. Seit einigen Jahren sind die beiden Technologien respektive Techniken nicht mehr wegzudenken, auch wenn längst nicht alle Spieler davon profitieren. Neben den hohen Preisen für die Beschleuniger stehen sie immer wieder wegen des realistischeren Looks und der besseren Performance im Rampenlicht.

Im Moment sind Raytracing und DLSS in aller Munde und es scheint beinahe undenkbar, dass es sie einmal nicht mehr geben könnte oder dass sie einfach keine Rolle mehr spielen. Doch die Geschichte lehrt uns, dass das dennoch der Fall sein kann. Das belegen auch die folgenden Beispiele von Techniken, die einmal angesagt waren, mittlerweile aber längst in der Versenkung verschwunden sind.

Multi-Grafikkarten-System: SLI und Crossfire

SLI und Crossfire waren gerade ab Mitte der 2000er- bis weit in die 2010er-Jahre der letzte Schrei unter Spielern. Die beiden Techniken von Nvidia (SLI) und AMD (Crossfire) machten es möglich, die Rechenleistung von zwei, drei oder gar vier Grafikkarten zu koppeln und so teils deutlich mehr FPS in einem Spiel zu erhalten. Mittlerweile sind SLI und Crossfire jedoch kaum mehr anzutreffen. Und das hat triftige Gründe:

- Hoher Aufwand für Entwickler: Zwei Grafikkarten miteinander zu verbinden und davon zu profitieren, hört sich einfacher an, als es ist. Entwickler müssen ihre Spiele extra dafür optimieren. Und das kostet Geld. Geld für eine Technik, die auch zu ihren besten Zeiten längst nicht jeder nutzte. Außerdem mussten nicht nur Game Developer Arbeit in die Entwicklung stecken, sondern zusätzlich auch noch die Grafikkartenhersteller selbst. Schließlich musste auch der Grafiktreiber die Funktion in einem Spiel unterstützen.

- Mikroruckler: Der Grafikkartenverbund hatte aber auch Nachteile für die Performance, selbst wenn ein Spiel darauf zugeschnitten war. Eines der häufigsten Probleme waren sogenannte Mikroruckler.

- Hoher Performance-Gewinn nicht garantiert: Und selbst die Performance-Gewinne hielten sich teils in Grenzen. Während sich die FPS in manchen Spielen tatsächlich fast verdoppeln ließen, konnte man in anderen oft nicht mehr als 30 Prozent und teils sogar weniger herausholen. Kosten und Nutzen standen hier oftmals in einem schlechten Verhältnis.

- Grafikspeicher: Ein Problem von SLI und Crossfire war zudem, dass sich zwar die Rechenleistung teilweise aufaddieren ließ, die Menge des Grafikspeichers allerdings nicht. Trotz grundsätzlich guter Leistung war der VRAM oftmals der limitierende Faktor.

Ganz verschwunden sind SLI und Crossfire übrigens nicht. Nvidia bietet SLI in Form von NVLink weiterhin an, allerdings nur für das Topmodell Geforce RTX 3090. Bei AMD unterstützen auch die kleineren Grafikkarten-Modelle Crossfire noch immer. Allerdings ist die Liste an Spielen mit entsprechendem Support mittlerweile recht kurz.

Nvidia 3D-Vision

Vor bald 13 Jahren ist der letzte große Hype um stereoskopisches 3D ausgebrochen. Und das nicht nur in den Kinos durch den Science-Fiction-Film Avatar. Etwas zuvor, genauer gesagt: Anfang 2009, hatte Nvidia mit 3D-Vision versucht, ein echtes stereoskopisches Erlebnis in Spielen zu etablieren. Dafür brauchte es eine sogenannte Shutter-Brille, die Inhalte mit speziell dafür ausgelegten Bildschirmen synchronisierte.

So funktioniert die Technik: Während der Bildschirm jeweils abwechselnd ein zueinander leicht versetztes Bild für das rechte und das linke Auge ausgibt, verdunkelt die Shutterbrille das Glas des jeweils anderen Auges. Dadurch entsteht der Tiefeneindruck.

Um 3D-Vision zu nutzen, musste man auch noch Einstellungen im Treiber der Grafikkarte vornehmen. Mittlerweile ist die Technik jedoch in der Versenkung verschwunden. Der letzte Treiber mit entsprechender Unterstützung erschien vor ziemlich genau drei Jahren.

Im Kino können wir stereoskopisches 3D immer noch bestaunen. Hier kommt in den meisten Fällen jedoch nicht die aufwändige Shutter-Technik sondern ein Polarisationssystem zum Einsatz. Dabei werden die Bilder ebenfalls für jedes Auge extra ausgegeben, allerdings in jeweils entgegengesetztem polarisierten Licht. Jedes der beiden Brillengläser ist daher ebenfalls entgegengesetzt polarisiert und lässt nur das Licht des passenden Bildes durch.

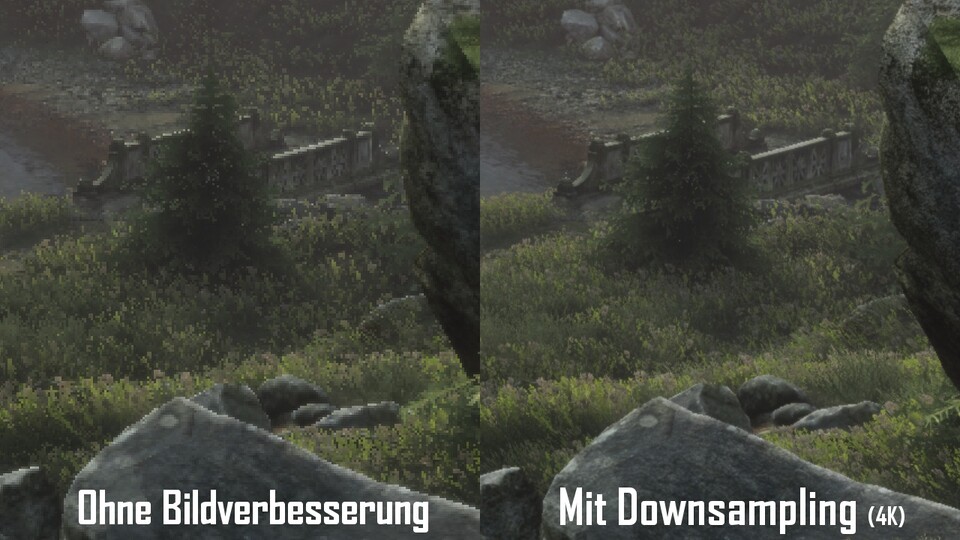

Kantenglättung MSAA

Anti-Aliasing ist aus Spielen so gut wie nicht wegzudenken. Die sogenannte Kantenglättung verbessert den Look erheblich, da sie unschöne Treppchenbildung vermindert. Bildschirme sind in quadratische Pixel, also ein Raster, unterteilt, weshalb Kanten nur dann glatt dargestellt werden können, wenn sie exakt dem Raster entlang verlaufen – was so gut wie nie der Fall ist.

Es gibt etliche verschiedene Methoden zur Kantenglättung. Eine der ältesten ist MSAA, das sogenannte Multisample-Anti-Aliasing. Dabei handelt es sich um eine spezielle Form des Supersamplings, bei dem Bildinhalte in einer höheren Auflösung gerendert und die so gewonnenen Daten für die Berechnung der Farbgebung der Pixel der eigentlichen Auflösung mit einfließen lassen. Das ist jedoch sehr rechenaufwändig, weshalb beim Multisampling-Ansatz nur bestimmte Bildbereiche verwendet werden. MSAA liefert dabei weniger gute Ergebnisse als beispielsweise das ebenfalls sehr alte SSAA (Supersampling Anti-Aliasing).

Beiden Techniken ist allerdings gemein, dass sie sehr viel Rechenleistung benötigen. Heutzutage trifft man sie daher nurmehr selten an. Viel geläufiger sind sparsame Methoden wie FXAA und TAA. Nvidias KI-gestützter Upscaler DLSS kann ebenfalls zur Kantenglättung eingesetzt werden.

Physik-Engine Nvidia PhysX

Genau wie das oben genannte 3D-Vision ist auch PhysX eine Technik von Nvidia. Obwohl das so nicht ganz richtig ist, denn ursprünglich wurde PhysX als Physik-Engine NovodeX bei dem gleichnamigen Schweizer Unternehmen NovodeX entwickelt. Nach einer Übernahme durch den Halbleiterhersteller Ageia im Jahr 2004 erwarb Nvidia den Physikbeschleuniger Anfang 2008.

Nvidia implementierte PhysX in die sogenannte CUDA-Programmierschnittstelle, mit der die Geforce-Grafikkarten angesprochen werden. Damals wurde die Technik als Revolution verkauft. Einsatz fand und findet sie bei der Simulation von physikalischen Effekten, beispielsweise für…

- Flüssigkeiten

- die korrekte Berechnung der Bewegung von Kleidung

- Explosionen und Trümmer

- Nebel und Rauch

PhysX kann unter anderem von der bekannten Unreal Engine und Unity genutzt werden. Aber warum ist die Technik dann überhaupt in einer Liste für Funktionen, die es nicht mehr gibt?

Ganz einfach: PhysX wurde von Nvidia explizit zur Verwendung mit seinen Geforce-Grafikkarten respektive CUDA vorgesehen. Da es sich durch diese Exklusivität niemals wirklich durchsetzen konnte, hat Nvidia bereits 2015 Teile der Software offen zugänglich gemacht. Allerdings nur jene Teile, die von Hauptprozessoren, sprich: CPUs ausgeführt werden können. Die Berechnung mit einer CPU kostete damals sehr viel Leistung. Mittlerweile sind die Probleme jedoch gelöst und die physikalischen Berechnungen in Spielen werden daher nicht mehr von der GPU sondern von der CPU ausgeführt. In seinem ursprünglichen Sinne wurde PhsyX also zu Grabe getragen.

Ein besonders bekanntes Spiel, das sich PhysX zunutze macht ist The Witcher 3: Wild Hunt. Der Rollenspiel-Dauerbrenner macht aber noch von einer ganz anderen, längst in Vergessenheit geratenen Technik Gebrauch:

Nvidia HairWorks

Und auch das stammt von Nvidia. Genau wie PhysX handelt es sich bei HairWorks um eine Physik-Engine. Allerdings ist sie, wie der Name bereits andeutet, ausschließlich auf die physikalisch korrekte Bewegung und den Schattenwurf von Haaren und Fell spezialisiert.

Eingeführt wurde Nvidia HairWorks 2013. Das erste Spiel mit entsprechender Unterstützung war Call of Duty: Ghosts. Danach folgte Far Cry 4 und später eben besagter Hexer Geralt. Final Fantasy 15 nutzt die Technik ebenfalls, weitere Spiele fallen uns so spontan aber nicht mehr ein. Dass generell so wenige Games davon Gebrauch machten, lag vor allem an dem vergleichsweise geringen optischen Mehrwert bei gleichzeitig deutlich spürbaren Performance-Einbußen.

Vermisst ihr eine der Techniken? Habt ihr vielleicht noch gar nie davon gehört? Oder waren sie euch auch schon damals völlig einerlei? Schreibt es gerne in die Kommentare!

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.