Am meisten Bewegung kommt 2013 noch in den Markt für Smartphones und Tablets, generell herrscht aber eher Evolution statt Revolution - vielleicht mit Ausnahme der neuen Konsolen. Mit den neuen Generationen von Geforce- und Radeon-Karten sowie Intels »Haswell«-Prozessoren und AMDs »Richland«-APUs mit schneller integrierter Radeon-Grafik bekommen alle wichtigen PC-Komponenten mit Ausnahme von AMDs Piledriver-CPUs eine Frischzellenkur, allzu große Leistungssprünge bleiben aber aus. Die gibt es aber auf dem Konsolenmarkt, denn Ende des Jahres soll zumindest die Microsoft Xbox 720 den Generationenwechsel einläuten. Am meisten Abwechslung und Spannung liefern die Neuvorstellungen von Smartphones und Tablets im Wochenrhythmus, die sich immer weiter annähern, aber auch durch Extreme voneinander abgrenzen wollen. Wir wagen einen Ausblick auf die kommenden Monate und klären, welche Produkte am wichtigsten werden und welche neuen Techniken sich durchsetzen.

PCs und Notebooks

Umwälzende Revolutionen oder bahnbrechende Erfindungen bleiben wohl auch 2013 ein Wunschtraum. Stattdessen gibt es im PC- und Notebook-Markt kleine Evolutionsschritte: Grafikkarten und Prozessoren werden im Wesentlichen noch schneller und etwas energieeffizienter. Intels neue CPU-Architektur namens »Haswell« ist wahrscheinlich die spannendste Neuerung im PC-Bereich, weil AMD und Nvidia ihre bekannten Grafikkarten-Architekturen nur aufwärmen und AMD gar keine neuen High-End-Prozessoren für veröffentlichen will.

Geforce GTX 780 & Co.

Jedes Jahr eine neue Grafikkarten-Generation, so lautet wohl das Motto von AMD und Nvidia. Über Nvidias kommende Geforce GTX 700 (oder wie auch immer sei heißen wird) gibt es derzeit nur viele Gerüchte, aber kaum etwas Handfestes. Angeblich soll der bereits exisiterende GK110-Chip, der zwar technisch auf dem aktuellen Kepler-Design basiert, aber derzeit noch auf keiner Desktop- oder Notebook-Grafikkarte zum Einsatz kommt, das Grundgerüst der kommenden Geforce-Serie werden. Mit 7,1 Milliarden Transistoren, 2.880 Shader-Einheiten und 384 Bit breitem Speicher-Interface überbietet der High-End-Chip den GK104 einer Geforce GTX 680 mit 4,3 Milliarden Transistoren, 1.536 Shadern und 256 Bit Speicher-Interface locker. Oder aber die bestehenden GK-Varianten der GTX-600-Serie werden hinsichtlich Leistung und Stromverbrauch verbessert, denn eine neue Architektur erwarten wir mit der Geforce GTX 780 nicht. Wann die ersten Modelle auf den Markt kommen, ist derzeit noch ungewiss, wir tippen aber auf April.

Radeon HD 8000 oder HD 9000

Von AMDs nächster Generation gibt es derzeit zwar keinen Namen, aber immerhin einige Gerüchte zu den Modellspezifikationen. Dass AMD die kommende Radeon-Generation HD 8000 tauft, halten wir für unwahrscheinlich, da der Hersteller auf der CES Anfang Januar 2013 bereits die vollständige Radeon-HD-8000-Serie für PC-Hersteller ankündigte - aber alle vermeintlich neuen Modelle sind nur umbenannte Karten der bekannten HD-7000-Reihe um die Radeon HD 7970. Bekannt sind dafür die Codenamen der wirklich neuen »Sea Islands«-Generation und dass diese auf der überarbeiteten »Graphics Core Next«-Architektur basieren, genannt GCN2. So sollen die kommenden Karten sowohl in Desktop-PCs wie in Notebooks sparsamer arbeiten und aufgrund einer höheren Shader-Anzahl und schnellerer Taktraten leistungsfähiger als die aktuellen Modelle sein. Angeblich sollen die neuen Grafikkarten bereits Ende März oder Anfang April auf den Markt kommen - wie auch immer sie dann heißen werden.

Intel Core i7 4770K mit neuer Haswell-Architektur

Nach »Tick« kommt »Tock« - und so bringt Intel 2013 mit den Haswell-Prozessoren eine neue Mikroarchitektur auf den Markt. Nach »Sandy Bridge« und »Ivy Bridge« sollen die CPUs mit Haswell-Kern nochmals mehr pro Takt und Kern leisten. Allerdings benötigen die neuen Desktop-Prozessoren der 4000er-Modellreihe dafür einen neuen Sockel mit 1150 Pins - es wird also in jedem Fall ein neues Mainboard fällig. Der maximale Stromverbrauch der Haswell-CPUs steigt gegenüber ihren Ivy-Bridge-Vorgängern von 77 Watt auf 84 Watt (TDP). Unverändert bleiben die Anzahl der CPU-Kerne sowie die Größe des Cache-Speichers. Mit sechs oder gar acht Kernen für den Mainstream-Bereich rechnen wir bei Intel-CPUs daher auch 2013 nicht. Allerdings soll die integrierte HD4600-Grafik bis zu 50 Prozent schneller arbeiten als die HD 4000 der Vorgänger. Damit könnte Intel dann langsam auch für Gelegenheitsspieler interessant werden, zumal Onchip-Grafiken in Notebooks die Akkulaufzeiten in der Regel deutlich verlängern.

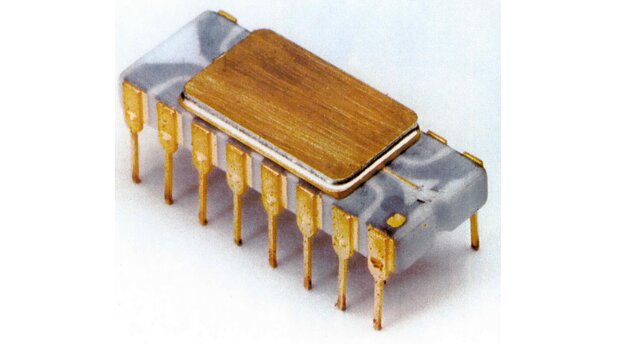

Intel-Historie - Von 1968 bis heute ansehen

AMD »Richland«-APUs mit stärkerer Grafik

AMD wird 2013 keine neuen Prozessoren für Spieler vorstellen, sondern konzentriert sich ganz auf stromsparende CPUs mit integrierten Radeon-Grafikeinheiten - die sogenannten APUs. Der Nachfolger der aktuellen Trinity-Generation hört auf den Namen »Richland« und bietet gegenüber den aktuellen Modellen wohl vor allem eine leistungsfähigere Grafikeinheit. Die Top-Modelle bieten je vier Rechenkerne und eine integrierte Radeon HD 8570D oder HD 8670D. Günstigere Modelle wie der A4 6300 oder A6 6400K besitzen nur zwei Kerne und einen schwächeren Grafikchip. Die Prozessor-Kerne basieren technisch aber noch immer auf dem »Piledriver«-Kern der bereits erhältlichen APUs wie dem A10-5800K. Gegen Mitte des Jahres sollen die ersten Modelle mit Richland-Kern auf den Markt kommen, erst 2014 sollen dann auch die FX-Prozessoren mit dem Piledriver-Nachfolger »Steamroller« erscheinen.

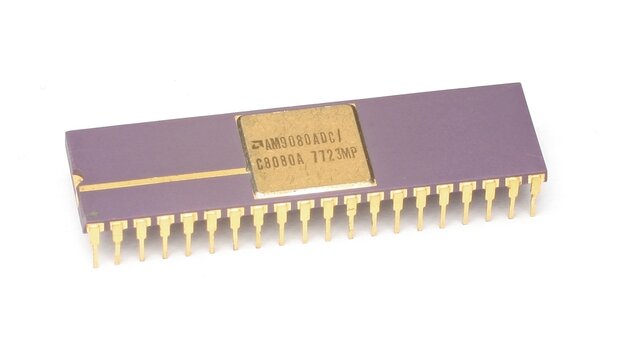

AMD CPU-Historie - 15 Prozessorgenerationen im Überblick ansehen

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.