Mit Bild-KIs sind und Illustrationen nur einen Klick entfernt - selbst dann, wenn das eigene künstlerische Talent überschaubar ausfällt. Tools wie Dall-E und Stable Diffusion bieten damit die Chance, visuelle Inhalte wie nie zuvor zu demokratisieren.

Doch was auf den ersten Blick so fair klingt, bringt eine Reihe von ethischen Problemen mit sich. Da ist etwa die viel diskutierte Frage, woher Bild-KIs ihr Trainings-Material erhalten dürfen und wie dahinterstehende Künstler fair entlohnt werden.

Ein weiteres Problem fliegt in der Öffentlichkeit hingegen eher unter dem Radar: Die KI-Bilder sind nicht frei von Vorurteilen. Wissenschaftler der Technischen Universität Darmstadt wollen das ändern.

Bild-KIs sind nicht frei von Vorurteilen

In die Trainingsdaten von Dall-E und Co. eingebacken sind unsere ganz eigenen Klischees. So berichtete etwa Technology Review über die Bild-KI Dall-E 2. Diese stellte CEOs in ihren Bildern nahezu ausnahmslos weiß und männlich dar. Gefängnisinsassen waren laut Wired hingegen überdurchschnittlich häufig Schwarz. Und bat man die KI um Bilder von Frauen, wurden die häufig sexualisiert und knapp bekleidet dargestellt.

Auch mit Parkplätzen scheint KI noch so ihre Probleme zu haben, wie ihr in Linhs Artikel nachlesen könnt:

Zwar arbeiten die KI-Unternehmen daran, diese Probleme aus der Welt zu schaffen. Gänzlich wird sich das Trainings-Material aber nicht von Vorurteilen befreien lassen - zumindest, solange wir Menschen nicht über unsere Klischees erhaben sind.

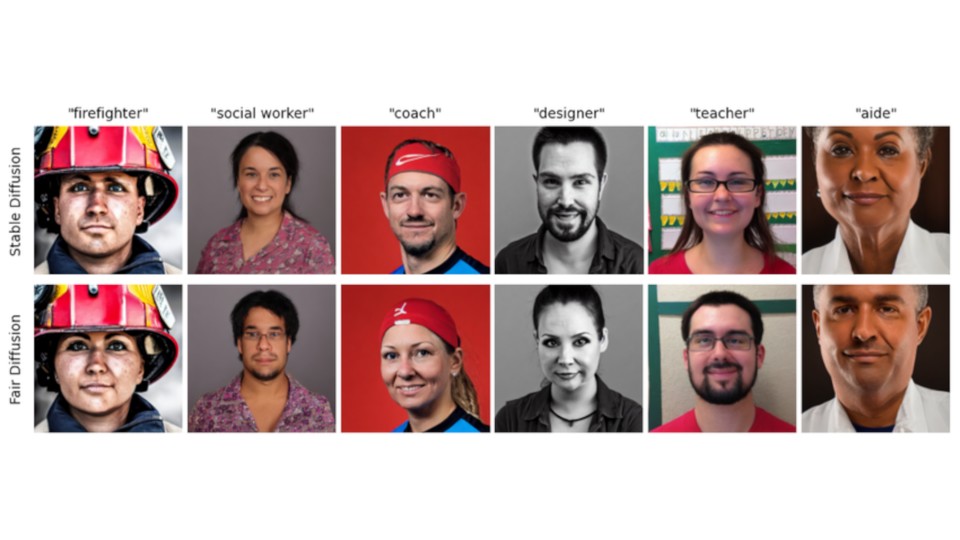

Hier setzen die Darmstädter Wissenschaftler rund um KI-Forscher Felix Friedrich an. Sie haben das KI-Tool Fair Diffusion entwickelt, mit dem sich Bilder per KI diverser gestalten lassen können.

Fair Diffusion sagt Stereotypen den Kampf an

Fair Diffusion soll vor allem bei der Erstellung von Text-zu-Bild-Inhalten zum Einsatz kommen - also KI-Tools, die aus Texteingaben Bilder erstellen.

Während der Erstellung der Bilder wird Fair Diffusion dabei zwischengeschaltet und sorgt für weniger Bias, wenn im Bild eine Person dargestellt wird.

Abseits der dargestellten Person soll das Bild dabei größtenteils unberührt bleiben und genauso aussehen, wie es die Bild-KI ohne Fair Diffusion erstellt hätte.

Bei den Personen im Bild soll Fair Diffusion hingegen für eine fairere Verteilung bezüglich Kategorien wie Hautfarbe oder Geschlecht sorgen, also etwa für mehr männliche Erzieher oder mehr weibliche Doktoren.

Dafür nutzt Fair Diffusion einen eigenen Datensatz, der aus mehr als 1,8 Millionen Bildern besteht und Personen in mehr als 150 verschiedenen Berufen darstellt.

Allerdings geben die Forschenden auch zu bedenken, dass es sich bei Fair Diffusion um kein völlig faires Tool handelt. Zwar könne man mit dem Tool spezifische Vorurteile innerhalb der Bilderstellung verringern. Eine KI, die auf einen Schlag alle Klischees aus der Welt räumt, sei es jedoch nicht.

Auch sei der von Fair Diffusion verwendete Datensatz selbst nicht ganz frei von Vorurteilen und Einschränkungen und stellt zum aktuellen Zeitpunkt etwa nur Personen mit binären Geschlechtsidentitäten dar.

Allen Einschränkungen zum Trotz könnten Werkzeuge wie Fair Diffusion künftig dafür sorgen, dass KI-Bilder fairer werden, anstatt wie bisher Stereotypen und Vorurteile wiederzugeben und sogar noch zu verstärken.

Was meint ihr? Verfolgt Fair Diffusion den richtigen Ansatz, um künftig für fairere KI-Bilder zu sorgen? Sollten Tools wie dieses vielleicht künftig sogar von Haus aus in Bild-KIs eingebaut werden? Oder sind Unterfangen wie dieses nur ein Tropfen auf den heißen Stein, solange wir selbst unsere Vorurteile und Klischees nicht loswerden? Schreibt uns eure Meinung gerne in die Kommentare!

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.