Gleich einmal eine Frage vorweg: Was hat sich in den letzten zehn Jahren bei den Computern alles getan? Vielleicht ist euer erster Gedanke, dass da eigentlich gar nicht so viel passiert ist. Gut, Grafikkarten sind schneller geworden und es gibt beinahe erschwingliche Virtual-Reality-Headsets, aber bei den Prozessoren herrscht doch fast Stillstand, oder?

Bei näherer Betrachtung schießen euch aber bestimmt eine ganze Reihe Dinge durch den Kopf: 4K-Auflösung war vor einer Dekade noch kein Thema, an Raytracing in Spielen war gar nicht erst zu denken und gekrümmte Ultra-Wide-Displays hatte auch noch niemand auf dem Schirm.

Doch wie wird es in weiteren zehn Jahren sein? Welche Technologien nutzen wir im Jahr 2030 (eigentlich 2032, aber das liest sich doch seltsam)? Wir werfen einmal einen Blick in die Zukunft und wagen die Prognose.

Spekulativ

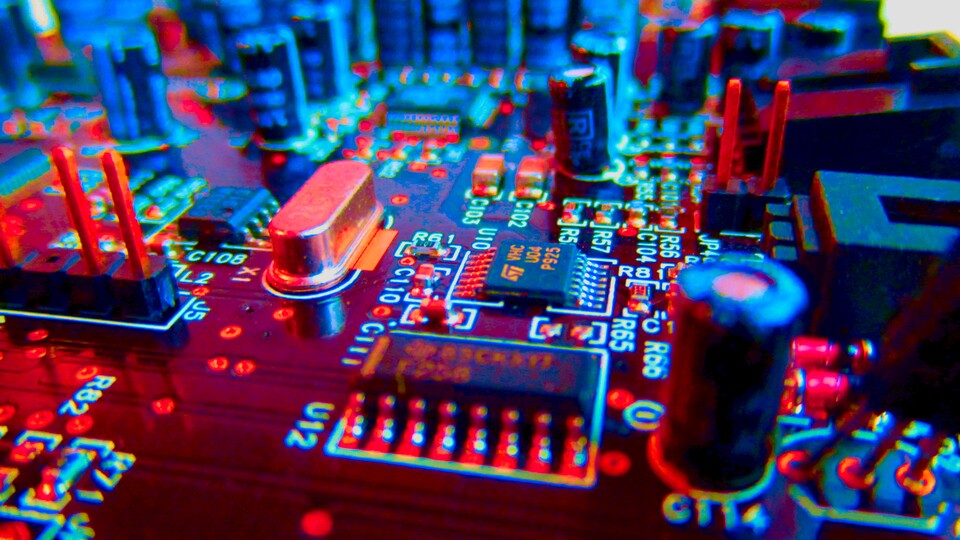

Fangen wir mit etwas höchst Spekulativem an. Wenn es um Computerchips geht, gibt es eigentlich zwei wesentliche Kenngrößen, die den Fortschritt markieren: Gigahertz und Nanometer. Die Gigahertz werden immer höher getrieben und die Strukturbreiten in Form von Nanometer stetig verkleinert, auch wenn Begriffe wie 10 oder 7 Nanometer längst von der tatsächlichen Strukturbreite entkoppelt sind. In der Regel fällt die tatsächliche Strukturbreite nämlich etwas größer aus.

Seit einigen Jahren bewegen wir uns jedoch rapide auf physikalische Grenzen zu. So etwa schalten herkömmliche Transistoren unterhalb von echten 5 Nanometer nicht mehr zuverlässig, da hier sogenannten Tunneleffekte auftreten. Das gilt zumindest für Silizium als Halbleitermaterial. Mit Molybdänsulfid kann diese Grenze unterschritten werden, aber auch das lässt sich nicht ewig fortführen. Ganz abgesehen davon, dass sich Transistoren auf Basis von Molybdänsulfid noch in der Entwicklung befinden.

Diese Grenzen sind auch ein Grund dafür, dass der Stromverbrauch bei Grafikkarten in Zukunft wohl vorerst steigen wird, wie auch AMD vorhersagt:

Gaming wird teurer AMD erwartet steigenden Strombedarf von Spiele-PCs, besonders bei Nvidia

#1: Neue Arten von Prozessoren

Ein viel grundlegenderes Problem als Taktfrequenz und Strukturbreite betrifft jedoch die Prozessorarchitektur. Praktisch alle modernen Computer basieren auf der sogenannten Von-Neumann-Architektur

, die eine strikte Trennung zwischen Rechenwerk, Speicher, Bus-System, Ein- und Ausgabe vorsieht.

Forscher gehen daher mittlerweile völlig neue Wege, um den sogenannten Von-Neumann-Flaschenhals

zu umgehen. Ein besonders bekanntes Beispiel hierfür sind Quantencomputer, aber es gibt auch noch andere Konzepte, um die Rechenleistung abseits von Gigahertz und Nanometer zu steigern:

- Neuronen statt Transistoren: Um den immer größer werdenden Aufgaben mit Blick auf KI-Algorithmen Herr zu werden, arbeiten Forscher an Schaltungen, die das menschliche Gehirn nachahmen. Die künstlichen Neuronen sind wie ihre biologischen Vorbilder und Synapsen hochgradig miteinander vernetzt und sollen daher einmal in der Lage sein, sich situationsabhängigen Aufgaben besser anzupassen und größere Datenmengen gleichzeitig anstatt nacheinander wie in einem Bus-System zu verarbeiten.

- Spinwellen: Um die Parallelisierung von Aufgaben zu erhöhen, wollen Forscher nicht mehr mit elektrischen Ladungen respektive Elektronen arbeiten, sondern mit deren Spin beziehungsweise deren Rotation. Vereinfacht gesagt, basieren moderne Computerchips auf der Bewegung elektrischer Ladungen. Eine elektrische Ladung entspricht einer Information. Es kann nur eine Information nach der anderen verarbeitet werden. Transistoren fungieren dabei als Schalter oder Verstärker. Spinwellen haben im Gegensatz dazu einige grundlegende Vorteile: Zum Beispiel ist die hohe Parallelisierung eine inhärente Eigenschaft von Wellen an sich. Die Datenverarbeitung basiert dabei auf der Überlagerung solcher Spinwellen. Wer sich mit dem Thema intensiver auseinandersetzen möchte, findet hier die passenden Informationen.

- Rechnen mit Licht: Ein Ansatz, der traditionellen Chips zwar sehr ähnlich, aber gleichzeitig viel leistungsfähiger ist, ist das Rechnen mit Licht, also mit Photonen anstatt Elektronen. Optische Transistoren schalten viel schneller als herkömmliche und brauchen dazu sogar deutlich weniger Energie. Es gibt zwar erste Prototypen solcher Transistoren, hier steht jedoch noch viel Entwicklungsarbeit bevor.

Die oben genannten Ansätze vereint vor allem ihre im Vergleich mit traditionellen Technologien hohe Rechenpower bei gleichzeitig besserer Energieeffizienz. Was wir davon letztlich wirklich in zehn Jahren sehen werden, ist allerdings offen, schließlich konkurrieren die Konzepte teils miteinander.

In diesem Zusammenhang ist es wichtig zu verstehen, dass es auch in Zukunft Anwendungsszenarien geben wird, in denen die herkömmliche Berechnung sinnvoller ist als beispielsweise eine hohe Parallelisierung. Alte und neue Technologien werden daher wohl nicht in gegenseitiger Konkurrenz stehen, sondern sich vielmehr ergänzen.

#2: Quantencomputer für jedermann

Das eben Gesagte gilt auch für Quantencomputer. Im Moment sind diese noch weit davon entfernt, in der Praxis eingesetzt zu werden. Erst müssen einige grundlegende Probleme gelöst werden, zum Beispiel die Fehlerkorrektur. Vereinfacht gesagt nutzen Quantenprozessoren keine elektrischen, sondern quantenmechanische Zustände wie zum Beispiel Superposition und Verschränkung. Dadurch können Quantenchips nicht nur eine Rechenoperation nach der anderen durchführen, sondern eine enorme Anzahl parallel.

Von allen neuen Konzepten für Prozessoren fließt mit großem Abstand am meisten Geld in die Entwicklung von Quantencomputern. Praktisch jeder große Techkonzern sowie viele entwickelte Staaten forschen an der Technologie, gerade weil sie große Vorteil bei komplexen Berechnungen wie beispielsweise der Verschlüsselung und Entschlüsselung von Daten verspricht – Stichwort: Quantenüberlegenheit. Damit ist ein Zeitpunkt gemeint, an dem Quantencomputer Probleme in einer akzeptablen Zeit lösen können, für die herkömmliche Rechner viele Jahre benötigen. Es gab bereits vielversprechende Meldungen hierzu, die meisten erwiesen sich jedoch als etwas übertrieben.

Bis in die frühen 2030er-Jahre dürfte sich bei den Quantencomputern jedoch einiges tun. Ob wir bis dahin Chips basierend auf der Technologie mit uns tragen, ist daher zwar denkbar, sagen lässt sich das jedoch nicht mit Sicherheit.

Nicht ganz so spekulativ

Kommen wir nun zu etwas weniger spekulativen Ausblicken in die Zukunft. Denn manche Dinge lassen sich von bereits bestehenden Technologien direkt in die kommenden Jahre extrapolieren. Zumindest, was die Entwicklung anbelangt. Denn ob solche Konzepte wirklich in der breiten Masse angenommen werden, steht noch einmal auf einem ganz anderen Blatt.

#3: Faltbare Geräte wohin das Auge blickt

Erste faltbare Geräte wie beispielsweise das Galaxy Z Fold 3 aus dem GameStar-Test gibt es bereits auf dem Markt. In Zukunft könnte sich deren Marktanteil jedoch deutlich erhöhen. Denkbar sind beispielsweise Smartphones, die man sich einfach um das Handgelenk schnallt und nicht mehr in der Hosentasche mit sich trägt. Oder auch Notebooks, die dann vielleicht so kompakt sind wie kleine Smartphones und unterwegs einfach auseinandergefaltet werden können.

#4: Sprechen mit dem Computer

Cortana und Siri sind die ersten Vorboten einer Technologie, die beinahe an den Computer

aus Star Trek erinnern. Amazons Alexa macht es ebenfalls bereits vor: Die direkte Kommunikation mit einem Rechner ohne den Zwischenschritt der manuellen Eingabe via Maus und Tastatur. Ganz wie auf den Enterprises von Kirk und Picard könnten wir in zehn Jahren Windows und MacOS tatsächlich größtenteils über Sprache steuern.

#5: KI wird zum Entwickler

In zehn Jahren könnten künstliche Intelligenzen respektive Algorithmen auf Basis maschinellen Lernens einen beachtlichen Teil der Spiele-Entwicklung ausmachen. Denkbar sind zum Beispiel große Open Worlds, die dann nicht mehr von echten Menschen, sondern von KIs mit Geschichten und Leben gefüllt werden. Überhaupt können es KI-Algorithmen Entwicklern deutlich leichter machen, Spielwelten zu erstellen. Ein Vorreiter solcher Systeme ist Nvidias neurales Netzwerk GameGAN, das vor zwei Jahren den Spieleklassiker Pac-Man nur durch Zusehen neu erschaffen hat:

#6: Cloudcomputing wird immer größer

In der nächsten Dekade werden wohl immer mehr Dienste in die Cloud abwandern. Wir kennen das bereits von Google Docs und Sheets, die Microsoft Word und Excel ersetzen. Und auch immer mehr Spiele werden direkt auf Servern in Rechenzentren gestartet anstatt auf dem heimischen Rechner. Ein gutes Beispiel hierfür ist der Streamingdienst Geforce Now, der es mittlerweile sogar möglich macht, Triple-A-Titel auf dem Smartphone mit 120 Hertz zu genießen.

Mit Google Stadia gibt es auch ein eher negatives behaftetes Beispiel, zumindest mit Blick auf das oft kritisierte Geschäftsmodell und den (bisherigen) Erfolg. Dennoch ist die Entwicklung zu immer mehr Onlinelösungen schon jetzt klar erkennbar und wird in zehn Jahren nur noch offensichtlicher und vor allem normaler sein.

#7: Virtual Reality erlebt einen Boom

Virtual Reality genauso wie Augmented und Mixed Reality fristen derzeit noch ein Nischendasein, auch wenn der Markt stetig wächst. In den nächsten zehn Jahren könnte VR jedoch einen ordentlichen Boom durchleben, ausgelöst vom potenziellen Aufstieg des sogenannten und vielbeschworenen Metaverse.

Hier jedoch gleich ein wichtiger Punkt: Virtual Reality und Metaverse sind nicht dasselbe, auch wenn es sich beim Metaverse naturgemäß um eine virtuelle Realität im Sinne von im Cyberraum befindlich

handelt.

Virtual Reality als technische Lösung mit Blick auf VR-Brillen wiederum kann ein Teil des Metaverse sein, muss aber nicht. Das Metaverse auf der anderen Seite ist ein gewaltiger, Kritiker befürchten sogar vollumfänglicher, persistenter virtueller Raum, der sowohl VR als auch alle anderen Interaktionsmöglichkeiten mit dem Internet einschließt.

Virtual Reality und Metaverse bieten sich jedoch als perfekte Symbiosepartner an. Ein Beispiel hierfür aus Film und Literatur ist die Romanverfilmung Ready Player One

. Apropos Zukunft: Was wir in diesem Jahr noch an Hardware erwarten, erfahrt ihr im GameStar-Podcast:

Link zum Podcast-Inhalt

Wie seht ihr das? Welcher der Technologien werden wir eure Meinung nach in zehn Jahren tatsächlich nutzen? Oder seid ihr euch sicher, dass es ganz anders kommen wird und wisst vielleicht, was wir nicht wissen? Schreibt es uns gerne in die Kommentare!

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.